智能阅卷工具在高考作文评分中的应用,确实在一定程度上提升了评分的公平性,但其实现程度需结合技术能力、人机协同机制及实际应用场景综合考量。以下是具体分析:

一、技术赋能:客观性与效率的提升

1. 标准化评分流程

智能阅卷系统通过高速扫描、图文转写和自然语言处理技术,将作文转化为结构化文本,并基于预先训练的评分模型(如主题契合度、语言流畅性、逻辑结构等维度)进行量化分析。例如,科大讯飞的系统会对比考生作文与范文库、题干内容的相似度,检测套作或雷同现象,减少人为疏漏。系统支持多维度特征抽取(如关键词匹配、语法错误识别),确保评分标准的一致性。

2. 人机协同机制

目前智能系统主要作为人工评卷的辅助工具。例如,每篇作文至少由两位阅卷人评分,若分差超过阈值,则由第三位教师或系统介入复核;对于零分或争议较大的答卷,甚至需要四评。AI通过实时分析评分差异,识别异常样本并反馈至专家组,形成动态质量监控。

3. 数据驱动的公平保障

系统基于海量历史数据(如历年高考作文及专家评分样本)训练模型,减少个体主观偏好影响。例如,安徽省高考中,AI评分结果与人工评分结果的比对分析已成为质检环节的重要依据。

二、现存挑战与局限性

1. 语义理解的深度不足

尽管AI能识别语法错误和关键词,但对作文的深层立意、情感表达及文化隐喻的解析仍有限。例如,部分实验显示,AI对中文发散性思维的捕捉能力弱于英语,可能导致对创新性作文的误判。大模型生成的“高分模板”可能被系统误判为优秀作文,而真正个性化的表达反而得分偏低。

2. 算法偏差与数据依赖

评分模型的公平性依赖于训练数据的代表性。若数据集中于某类文体或主题(如议论文占主导),可能对诗歌、散文等体裁评分不公。手写识别错误(如潦草字迹)可能导致转写偏差,影响后续分析。

3. 人机权责边界模糊

目前AI评分的透明度和可解释性不足,教师可能过度依赖系统建议,削弱主观判断的主动性。例如,某实验显示,不同AI模型对同一篇作文的评分差异可达20分以上,反映出算法标准的不确定性。

三、未来发展方向

1. 增强语义理解与创新性评估

结合深度学习与领域知识图谱,提升对作文逻辑链、论证深度及文化内涵的解析能力。例如,通过“评分特征+创意系数”综合计算,区分模板化写作与原创性表达。

2. 动态优化评分模型

引入增量学习技术,根据每年高考作文的新趋势(如科技、文化传承等热点)更新模型,避免评分标准固化。

3. 完善人机协同流程

明确AI的辅助定位,例如限定其处理基础评分(如语法检测、结构分析),而将立意、文采等主观维度交由人工评定,并通过区块链技术记录评分过程,增强可追溯性。

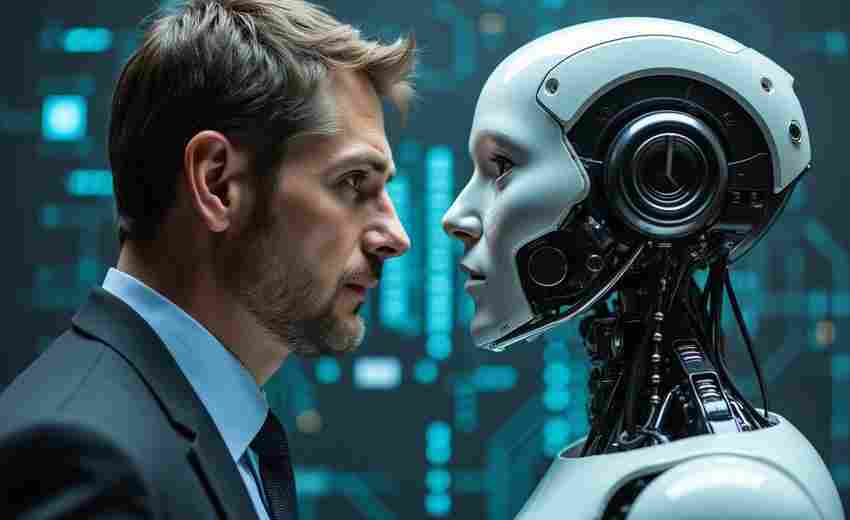

四、结论

智能阅卷工具通过标准化流程和客观数据分析,显著减少了人为误差和主观偏向,提升了评分的整体公平性。其完全替代人工评分仍不现实,尤其在处理创新性、复杂性作文时需依赖人机协同机制。未来,技术的持续迭代与评分标准的动态优化将是实现更高层次公平的关键。

推荐文章

如何选择适合自己的听力材料

2024-12-08新能源专业的未来前景如何

2024-12-15高考语文命题中语言学理论的应用与改革方向探讨

2025-04-03怎样结合高考成绩选择学术氛围匹配的高等院校

2025-04-05压线专业选择中理科与文科的学科优劣势对比分析

2025-08-01社会学专业的研究内容有哪些

2025-01-14传媒与广告专业在武汉的差异

2025-01-17高考语文、数学、外语三科满分均为150分吗

2025-03-11河南大学的学习支持服务有哪些

2025-02-10总分总结构在高考作文中有哪些应用技巧

2025-06-29